凌晨,OpenAI 公布了其新模型 GPT-4o,o 代表的是 omni, 意思是无所不包,无所不能

- 多模态交互:能够处理文本、音频和图像输入,并生成文本、音频和图像输出,这标志着向更自然的人类-计算机交互迈进了一步。

- 响应速度:能够以极快的速度响应音频输入,平均响应时间仅为 320 毫秒,与人类对话的响应时间相似。

- 性能提升:在文本(包括非英语语言)、代码性能上与 GPT-4 Turbo 相当,同时在视觉和音频理解上有所提升。

- 端到端模型 是一个经过端到端训练的单一新模型,可以处理文本、视觉和音频数据,这意味着所有的输入和输出都由同一个神经网络处理。

- 能力探索:官网中列举了 GPT-4o 的多种能力,如两个 GPT-4o 互动唱歌、面试准备、猜谜游戏、理解讽刺、数学问题解答等。

- 模型评估:在传统基准测试中达到了 GPT-4 Turbo 水准的性能,在多语言、音频和视觉能力上设立了新的高标准。

- 语言标记化:的新标记器在不同语言家族中都有所压缩,减少了所需标记的数量,这有助于提高处理多种语言的效率。

- 安全性和局限性:通过过滤训练数据和训练后的行为优化等技术内置了安全性。它还经过了自动化和人工评估,以确保在网络安全、化学、生物、放射性和核安全、说服和模型自主性方面的风险不超过中等水平。

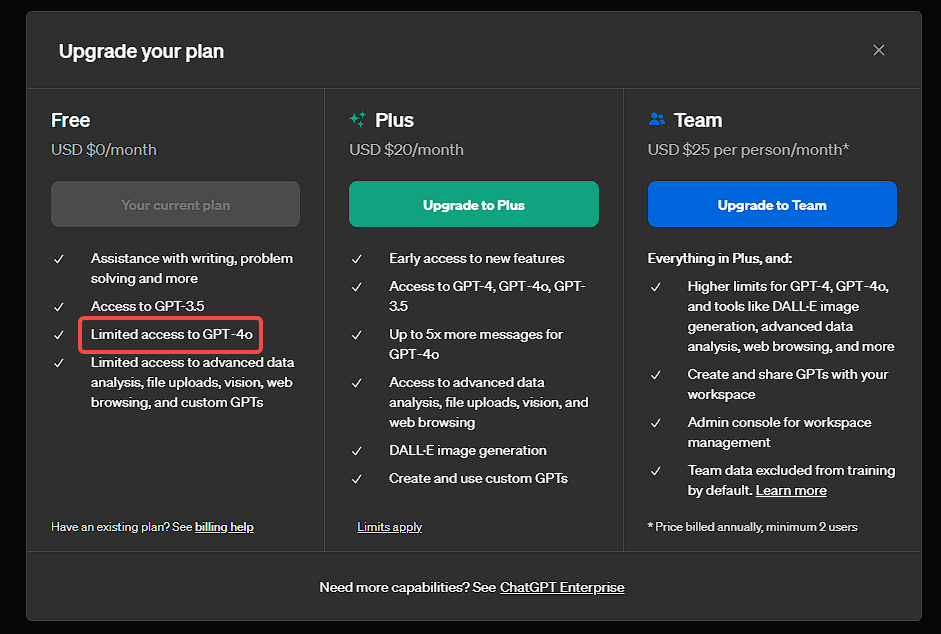

- 模型可用性:GPT-4o 的文本和图像功能开始在 ChatGPT 中推出,并向 Plus 用户提供更高的消息限制。GPT-4o 也在 API 中作为文本和视觉模型提供,比 GPT-4 Turbo 更快、更便宜,并且有更高的速率限制。

GPT-4o 的新功能将逐步推出,首先是文本和图像,然后是音频和视频功能,这将在未来几周和月份内进行。

如果你进入了灰测资格,可以直接访问这个链接使用:

还有一个值得注意的是,如果你是白嫖党,那么 GPT-4o 是可以免费使用!Plus 用户只是额度更多,并能早点用 MacOS 客户端, 一并免费的功能还有浏览、记忆功能、数据分析。

官网还有很多示例,感兴趣的可以直接去看:

商业转载请联系三花微信公众号获得授权,非商业转载请注明本文出处及文章链接,您可以自由地在任何媒体以任何形式复制和分发作品,也可以修改和创作,但是分发衍生作品时必须采用相同的许可协议。

本文采用 CC BY-NC-SA 4.0 - 非商业性使用 - 相同方式共享 4.0 国际 进行许可。